2016年,山西大学科学技术史研究所的厚宇德教授对杨振宁先生做了一个访谈。其间,杨先生比较系统地讲了自己对科学与哲学的关系的一些看法,他的观点是本文讨论人工智能与哲学关系的一个起点。

杨先生认为,在19世纪时,科学仍然被当作自然哲学,并被认为从哲学脱胎而来。即使到了19世纪末,马赫(Ernst Mach)等科学家依然认为物理学和哲学密不可分。而在相对论和量子力学建立之后,哲学对物理学的影响就变得越来越小,甚至量子力学的观念开始反过来影响哲学家对“何为实在”的理解。

当谈到日本著名物理学家坂田昌一认为理论物理研究需要哲学指导这一观点时,杨先生说:“我不同意他说自己的研究源于哲学的观点,他从哲学出发得不出物理学结论,我认为他越少涉及哲学的时候,物理成就才越大。”他的表达比较温和,但大抵持有哲学和科学彼此分离的观点。而像霍金、费曼这些物理学家,不仅认为哲学和科学是分离的,甚至认为当今的哲学对于科学而言几乎没有任何价值。

以极为粗糙的视角回顾20世纪的科学史,其间有两次重大的科学进展:一是上半叶发生的以相对论和量子力学为核心的物理学革命,二是下半叶兴起并一直发展至今的人工智能科学。在物理学观念革新的背景下,产生了以石里克(Moritz Schlick)等为代表的逻辑经验主义,也称维也纳学派。该学派致力于拒斥传统形而上学,主张研究、分析、澄清科学理论中真正发挥作用的概念。而哲学就是一种概念澄清活动。这次物理学革命的后果是物理学与哲学逐渐分家,哲学不再指导物理学,而哲学家需要了解物理学,从中获取对哲学的“指引”。于是,当今的风潮变成了以物理学为基础范式的科学哲学、哲学乃至人文社会科学。从维也纳学派的主将纽拉特(Otto Neurath)、卡尔纳普(Rudolf Carnap)提出的语言学的物理主义,一直到现在仍然处于争论核心的本体论的物理主义,就是物理学革命在哲学上的一个代表。与此相反的主张是二元论,即认为除了物理的东西,心灵的东西也是基本存在之物。如今,物理主义与二元论的争论是心灵哲学中的一个基本争论。

如果说物理科学在哲学上形成了主流的物理主义世界观,那么人工智能的发展也形成了一种哲学上的主张——计算主义:把心灵视为一个计算系统,思维都是可以通过计算得到的。与此相反的主张认为情感是不可计算的。今天我们可以看到,计算是人工智能最为核心的观念。

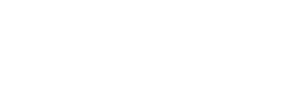

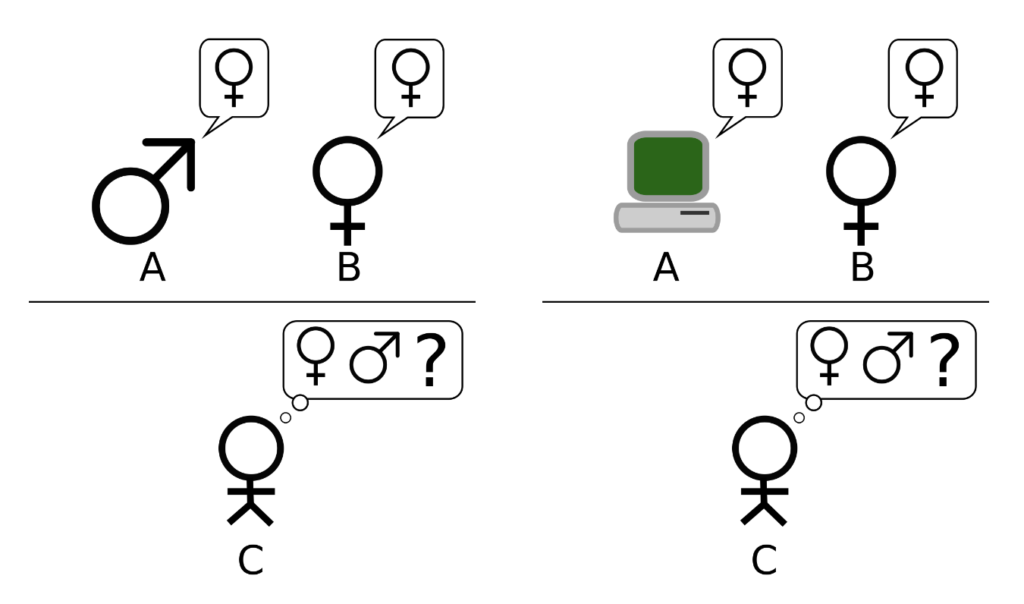

20世纪40年代,人工智能研究悄然兴起。1950年,图灵在发表于哲学顶级杂志《心灵》上的《计算机器与智能》一文中提出了后来广为人知的“图灵测试”:把一个人和一部机器安排在两个不同的房间里,测试者通过文字和他们进行对话;经过一段时间的交流,如果测试者不能区分出谁是机器谁是人,那么机器人就通过了测试,且表明机器是可以思考的。

上述是大家通常理解的“图灵测试”,但更准确的表述是这样的。有一个原初的“模仿游戏”:一个男人和一个女人被安排在两个不同的房间,测试者用文字和他们对话。还有一个升级版的“模仿游戏”:一个男人和一部机器被安排在两个不同的房间,测试者用文字和他们对话。如果最终测试者在两次游戏中能准确判断出哪一个是男人的概率大致一样,就说明机器在功能上成功模拟了女人的思维。图灵成功地把“机器是否可以思考”这个问题转变为两个“模仿游戏”中的测试者判断出谁为男人的成功概率,使得这个问题变得可以操作,这是革命性的一步。

可以看到,图灵并没有强调要造出具身的机器人,而是抓住了人类的一个本质特征——语言,以此为衡量机器人是否具有智能提供一个基本的标准。今天,以大语言模型为基础的ChatGPT成了最具影响力的人工智能产品之一,这不得不让人想起图灵70多年前的洞见。语言为什么重要?20世纪时,哲学发生了一次著名的语言转向,以弗雷格、罗素、维特根斯坦为代表的哲学家把哲学对世界的关注拉到语言上。从这个角度来看,人工智能经历了从重视逻辑语言到关注自然语言的变化。早期人工智能关注符号,关注逻辑推理,但它有一个根本的缺陷,即不能解决一些常识推理问题。将逻辑推理应用到人工智能,不能不谈到逻辑学家的贡献。中国的逻辑学家王浩先生就因在机器证明领域的贡献于1983年获得由国际人工智能联合会授予的第一届“数学定理机械证明里程碑奖”。

在人工智能的发展中,哲学家一直在从哲学的角度对机器和人的关系提出新的思考。分析哲学家塞尔(J. R. Searle)在1980年提出了名为“中文之屋”的思想实验,设想了一个可以使用中文和他人进行有效交流的机器,这个机器可以交流信息,却不理解汉语,因此他认为机器是不能真正思考的。直到现在,很多学者还在沿用塞尔的这一思路来批评当前的人工智能,包括ChatGPT。

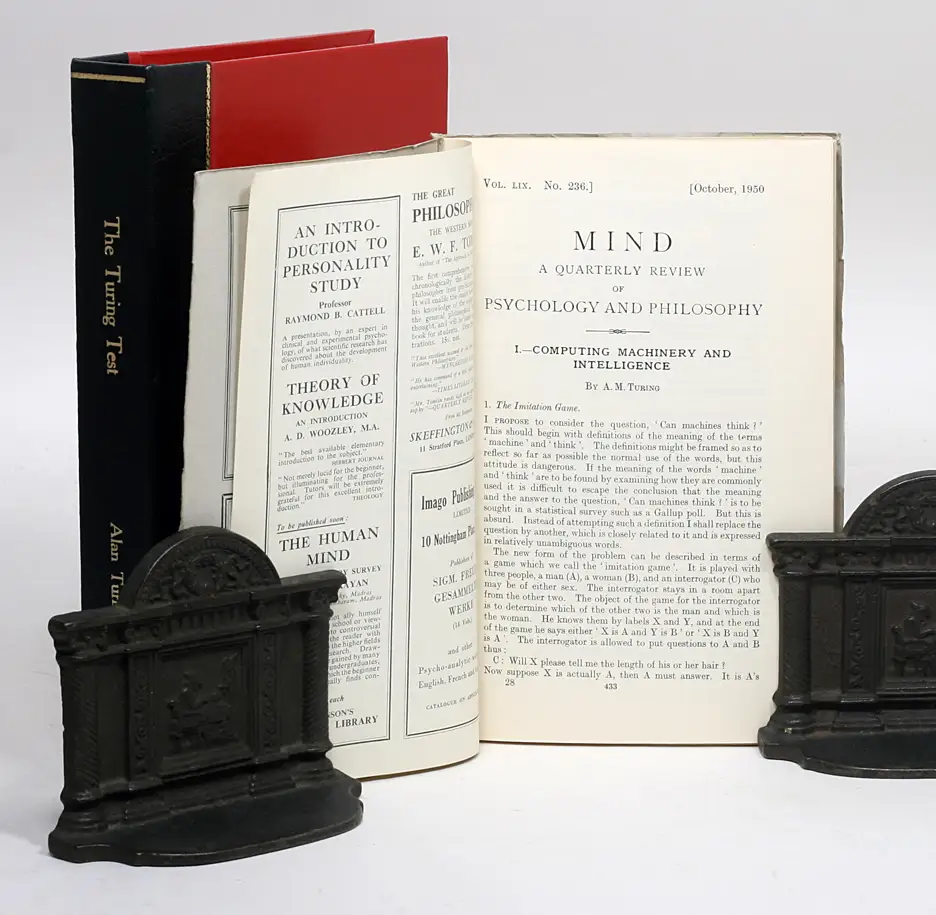

现象学家德雷福斯(Hubert L. Dreyfrus)认为真正的智能需要具身,机器需要像人一样在真实的环境中生活。因为人和世界的关系并不仅仅是心灵与世界的关系,大脑连着身体,身体连着环境,人的认识发生在大脑-身体-环境的互动过程之中。具身智能、环境智能、延展智能是认知科学研究的主流。还有一些哲学家用新的科技智能技术去重新设想传统的怀疑论问题、生活价值问题等。普特南(Hilary Putnam)的“缸中之脑”借用了神经科学的技术,设想把一个人的大脑放在充满营养液的玻璃缸中,用各种电极连接,帮助他产生一种堪比真实的感觉:当他以为自己在太行山间徒步旅行,实际上他的大脑被浸泡在玻璃缸里。伦理学家诺齐克(Robert Nozick)在此基础上提出了“经验机器”的思想实验:如果人一辈子就活在这样的虚拟世界里,这样的生活是不是有价值的?

哲学和人工智能的关联要比哲学和物理学的关联更为内在。人工智能的一个基本立足点是从人出发,物理学的出发点是自然现象,数学的出发点则是公理。数学和物理学研究不以人为对象,也不以解释人的特征为目的。但是人工智能里有关于人的各种考虑。我们需要从人的智能出发去思考机器的智能,即便人的智能不是唯一的标准,这也是思考人工智能的出发点。图灵关于机器可以思考的考虑,利用的就是人类对于思考的直觉。也正是因为人工智能以人为出发点,在它诞生之初,哲学就与其同行。

按照苏格拉底开创的哲学传统,哲学就是认识你自己。当我们思考人工智能能不能做推理,有没有意识、情感、道德等时,都无法摆脱对人的推理、意识、情感、道德的思考。人工智能帮助我们认识自己,也因此从哲学内部生长出了人工智能哲学这一分支领域。一个时代有一个时代的问题,从一个侧面来看,智能和意识问题就是我们这个时代的哲学问题。哲学与科学的关系代替了哲学与宗教的关系,成为这个时代的基本关切。

我们可以将哲学与科学的关系归结为以下四种:其一,科学从属于哲学,这是传统的自然哲学立场;其二,哲学从属于科学,这是20世纪以来的科学进展的产物;其三,哲学与科学互不干涉,哲学的归哲学,科学的归科学;其四,哲学与科学互相影响,互相滋养。传统的思想家既是科学家也是哲学家,亚里士多德、笛卡尔、牛顿都革新了我们对于世界整体图景的理解。爱因斯坦和哥德尔是最后两位兼具这一双重身份的思想大师,之后物理学和数学的发展就不再是一种观念性的革命了,它们距离哲学越来越远。曾经一体的哲学和科学经历了漫长的分家,之后又开始合流,出现了新文科、跨界、交叉、融合。但这种交叉和融合只是挂了平等之名,实则以科学的方法和结论与其他领域融会贯通。

尽管哲学被认为不再能指导科学,但其仍可以助力科学,厦门大学的朱菁教授称“哲学是科学的助产士”。但最近,我们听到这样一种说法:传统哲学的框架不适合讨论现在的哲学问题了。从AlphaGo击败李世石、战胜柯洁开始,自动驾驶、人脸识别、图像识别、自然语言处理等技术迅猛发展,这背后是以机器学习为底层逻辑的胜利,有人将之总结为经验主义的一次胜利。如果这些只能算作前奏,那么元宇宙一时间火遍神州大地,可谓“推波助澜”。2023年,ChatGPT又将人工智能再次推到高潮。然而,科学家制造了奇迹,哲学家却无法解释这个奇迹,这就是现在人工智能面临的解释困境。

我把当前人工智能的解释困难总结为解释的两难:如果人工智能是可解释的,那么它在解决实际问题时就没有太多用处;如果人工智能在解决实际问题时非常有效,那么它就是没法解释的。可解释的人工智能是早期的符号人工智能以及近几年兴起的因果人工智能,面临解释困境的则是以神经网络为底层逻辑的机器学习人工智能。如何让这一底层逻辑变得可以解释,是哲学家和科学家需要共同面对的难题。

在这里,我想简单回顾一下人工智能推理的底层逻辑的发展,来看看人工智能与哲学的关系。我曾从因果推理的视角将其分为三个阶段:一是早期的基于符号逻辑的推理,二是基于概率统计的推理,三是因果推理。符号逻辑推理不能解决常识推理问题,概率推理不能解决因果推理问题。2011年的图灵奖得主珀尔(Judea Pearl)认为计算机需要具备因果推理能力,因果推理也因此成为近十年来人工智能研究的热门,但其目前的可应用性依然很低。如果说符号逻辑推理的问题是解决不了某些常识问题、情景问题,那么因果推理的问题则是它虽然能解决这些问题,但还无法让智能系统获得因果语言。

在统计学中有一个共识——相关不蕴含因果,即两个事物之间的相关关系并不是因果关系。为了表达因果关系,珀尔构造了因果关系的三层阶梯:第一层是相关关系,第二层是干预关系,第三层是反事实关系——只有用反事实才能表达真正的因果关系。因果关系不能用概率语言表示,而是需要用因果语言来表示。这样就陷入了一个僵局,因为现有的计算机无法使用因果语言,只能运用相关性语言。有学者批评人工智能缺乏真正的理解、不会做因果推理、常识推理,都是基于上述对相关和因果关系的理解。

但我想不揣冒昧地表达一个不同的观点:虽然相关不蕴含因果,但我们却可以从相关性推理中获得有效的结论。例如,传统人工智能不能做的常识推理、因果推理或类比推理,我们可以从以大语言模型为基础的ChatGPT中获得。为什么ChatGPT可以从相关性中得出因果?一方面,ChatGPT的底层逻辑是基于神经网络的学习模型,具有一定的“自主”学习能力;另一方面,它所获得的数据库是人类的语料库。这两方面保证了它可以做出很多令人惊异的推理。其中的道理并不复杂,因为人类的语言中凝结了我们对世界的理解以及对自己的认识。维特根斯坦说:“想象一种语言就是想象一种生活形式。”人类的语言里有因果、类比、想象,只要大语言模型具备相应的语言数据库,它就可以通过机器学习的方式从语言数据中获得新的东西。需要强调的是,这里的语言数据并不是单纯的数据集,而是已经被结构化的数据。所谓结构化,就是自然语言表达中带有的各种各样的表达所产生的结构。以因果结构为例,我们的语言里有各种各样的因果语词(“因为……所以”“影响”“打败”“击倒”等),一个没有因果的语言,是无法用来进行任何交流的。大语言模型的胜利并不完全是一种经验主义的胜利,语言的结构并非单纯是经验的。用哲学的行话说,大语言模型是一种理性主义和经验主义结合的胜利。

2023年3月,纽约大学召开了一次机器学习哲学的会议,就“大语言模型理解世界是否需要具身”这一话题进行辩论。杨立昆(Yann LeCun)认为如果要用大语言模型理解世界,就需要世界模型。我认为这个世界模型的基本框架就在语言之中,让机器人具身能更充分地理解语言,但语言模型本身保障了最基本的理解。卢普言(Gary Lupyan)认为具体词和抽象词的意义深嵌于语言中,语言模型可以做类比推理,他让ChatGPT想象自己是森林里的小虫子,然后问它可以用什么作雨伞。结果,ChatGPT给出了一系列可以当作雨伞的东西,如树叶、蘑菇、草等。这就表明,纯文字的语言模型也能够理解人类语言中“雨伞”的核心概念。这场辩论背后更大的问题是:语言和思想以及世界的关系是什么?语言的边界在哪里?我认为语言本身就具有我们需要的很多东西,我们平时可以听到“语言的边界就是思想的边界”“语言是存在的家园”“诗到语言为止”,ChatGPT为这诸多说法提供了一个阐释的可能。

有人说ChatGPT只会做出愚蠢的回答,但真实情况也许是“愚蠢的问题才会导致愚蠢的回答”。我们需要对ChatGPT进行不断追问,在既有的答案上反复修改提问,从而抵达思考的深处。有数学家运用ChatGPT来证明数学定理,并把这种提问称为“苏格拉底式对话”。但哪一项是和问题真正相关的?或者语言模型如何提取相关的数据?这需要我们不断地优化问题。我想正是因为如此,ChatGPT展示了一种实用主义的哲学气质,它没有提供一锤定音的答案,而是需要在不断的诘问下获得逐渐逼近真理的答案。

ChatGPT的底层逻辑在根本上是基于统计、相关的,但是它依然可以从相关性中获得因果,关键就在于它所拥有的数据并不是盲目获取的,而是包括了具有因果、类比、常识结构的日常语言数据。乔姆斯基称ChatGPT是剽窃,也是发现它借用了语言本身的力量获得了超凡的技能。

ChatGPT提示我们,我们对何为理解、何谓推理的哲学解释需要调整,它所展现的回答并不按照常人所理解的模式进行,但它仍可做人类可做之事。在此意义上,新的智能技术挑战了我们固有的哲学理解——我们曾固执于有内外、主客之分的语义模型和心灵模型,乃至认为以具身为认识基础的观念需要得到根本的调整。

早在人工智能诞生之初,人们就对它有很多直观的思考:它具有像人一样的智能吗?它具有像人一样的意识吗?这组问题涉及两个常见的评判人工智能的标准:第一个是和人有关的本质主义的标准,认为人类智能是一切智能的标准;第二个是脱离人类中心的、家族相似的标准,主张万物平等,不同的物种具有不同的智能。

基于此,人工智能发展存在两个方向:一是超级智能方向,不追求和人类的生理、思维特征一致,如主张机器证明、科学发现,强调具有强大的计算能力、处理能力等;二是人类智能方向,关注常识推理、情景推理、因果推理、情感、意识等。ChatGPT既可以做到超级智能的事情,也可以做到人类智能的事情,这其实提示了人工智能的第三种可能性:融合智能。借用“一阴一阳之谓道”的说法,超级智能和人类智能是一个铜板的两面,要实现真正的人工智能,二者缺一不可。

一方面,我们不能完全摆脱人类的智能和意识去谈论智能和意识,另一方面又需要开拓新的智能和意识模式。但是对于人工智能和意识的定义,是不能用下定义的方法去解决的,只有新的技术和现实才会为我们带来新的理解。至少现在还不是说ChatGPT具有像人一样的意识的时候,说它有或者绝对没有意识,在我看来都是一种来自科学或哲学的偏见。不久前,来自计算机科学、生物学和神经科学领域的三位学者在Cell(《细胞》)子刊Trends in Neurosciences(《神经科学趋势》)上联合发文[1]表明大语言模型不具有意识。其中一个核心的论据就是,他们认为大语言模型不具有像人类一样的生物基础,“我们目前只能确定一种意识的存在,它来自嵌入复杂身体的大脑”。但这不过是说机器的意识需要像人的意识一样,这种批判并非新论。科学家应该更深入地认识大脑的机制,认识大语言模型的机制,认识二者之间的相似和差异,而不是去判定大语言模型有没有意识。我认为应该放弃讨论大语言模型是否具有意识这样的问题,保持一种认知上的谦虚,甚至像维特根斯坦一样在某些问题上保持沉默,而不是做哲学或科学的想象或批判。

人工智能与哲学的塑造是双向的。我们曾经经历过哲学影响人工智能的时期,现在更多的则是人工智能在影响哲学。这种影响并不意味着哲学的消失,一种新形态的哲学正在浮现,即和技术紧密结合、从技术本身出发来探究的哲学。这种新的哲学并不是一种技术哲学的通俗版本,而是一种真正的技术哲学。没有对技术本身的深入了解,就不可能产生有关它的好的哲学理论。我们现有的哲学理论也是先哲在面临他们那个时代的技术时提出来的,并不一定具有跨越时代的可应用性。基于牛顿力学的认识论是无法解释相对论和量子力学中的哲学问题的,我们也不能期望以物理学为基本模型的哲学理论可以解释现在人工智能中的哲学问题。牛顿的力学理论体现在康德的哲学理论之中,爱因斯坦的相对论体现在逻辑经验主义的诸多著作之中,人工智能的诸多理论也应该有与之匹配的哲学理论。这就呼吁哲学家多了解一些前沿的智能技术,科学家多了解一些基本的哲学问题和概念。只有双向对话才能推进智能科学与哲学的进步。

再多说一句,任何科学在发轫期都和哲学有紧密联系,但随着科学的专业化,它逐渐和哲学分家,数学、物理学、生物学都是如此。但人工智能科学和上述科学不同,它在发展期也一直和哲学同行。这是因为人工智能总是绕不过人的智能和意识,不管是选择人类智能的路线还是非人类智能的路线,人的标准总伴随人工智能的发展。而哲学家的基本工作就是研究人,研究人与他人、人与社会、人与自然的关系。一言以蔽之:人的科学离不开人的哲学。因此,在哲学与科学的关系立场上,我选择第四种立场:哲学与科学互相影响,互相滋养。这也是当前学科跨界融合应该选取的立场。

意识和智能是我们这个时代的哲学问题。当牛顿发现万有引力,当拿破仑的铁骑踏进德意志领土,当希特勒闪击波兰发动二战,这些时代的重大事件都以某种方式进入了哲学,影响了康德、黑格尔和萨特的哲学。如果说传统的重大事件重塑了哲学,那么人工智能作为我们这个时代的重大事件也具有类似的效用。最终,我们拥有的将不仅仅是人工智能哲学这一分支学科,哲学本身也会因为人工智能的发展而拥有了更为丰富的内涵。![]()

本文经授权节选自2024年2月出版的《信睿周报》。